即可将网页分享至朋友圈

近日,自动化工程学院2021级自动化专业本科生叶铭在中国科学院一区TOP期刊《Neural Networks》上发表了题为“Near-field millimeter-wave and visible image fusion via transfer learning”的研究性论文。该文首次提出毫米波近场透视成像与可见光的图像融合方法。叶铭为该论文第一作者,电子科技大学自动化工程学院为第一完成单位,李西峰副教授为通讯作者且为叶铭的指导教师,共同作者还有李艺通、吴帝、毕东杰、谢永乐。该研究在自动化学院谢永乐教授“电磁与声波测量”团队完成,得到该团队主持的国家自然科学基金“国家重大科研仪器研制”项目的支撑。

随着目标检测技术的快速发展,多种传感器在提升检测精度方面发挥着关键作用。可见光传感器(如摄像头)在捕捉纹理、结构信息方面表现出色,但仅限于获取表面信息,在遮挡或复杂环境下其检测能力受限。为弥补这一缺陷,近场毫米波成像技术因其具备透视能力、非破坏性检测和生物安全等特性,受到广泛关注。该技术能够通过处理回波生成高分辨率的内部缺陷图像,特别适用于工业制造、建筑检测和航空航天等领域的质量控制与安全检测。然而,传统毫米波成像面临特征稀疏的问题,导致生成的图像信息单一,难以满足高精度检测需求。针对无损检测、遮挡条件下的目标定位等场景,毫米波与可见光图像的融合提供了一种有效的解决方案。随着多视角智能检测需求的增加,高效整合多模态图像信息以提升目标表征能力,已成为亟待解决的研究课题。然而,目前尚未开展相关研究。

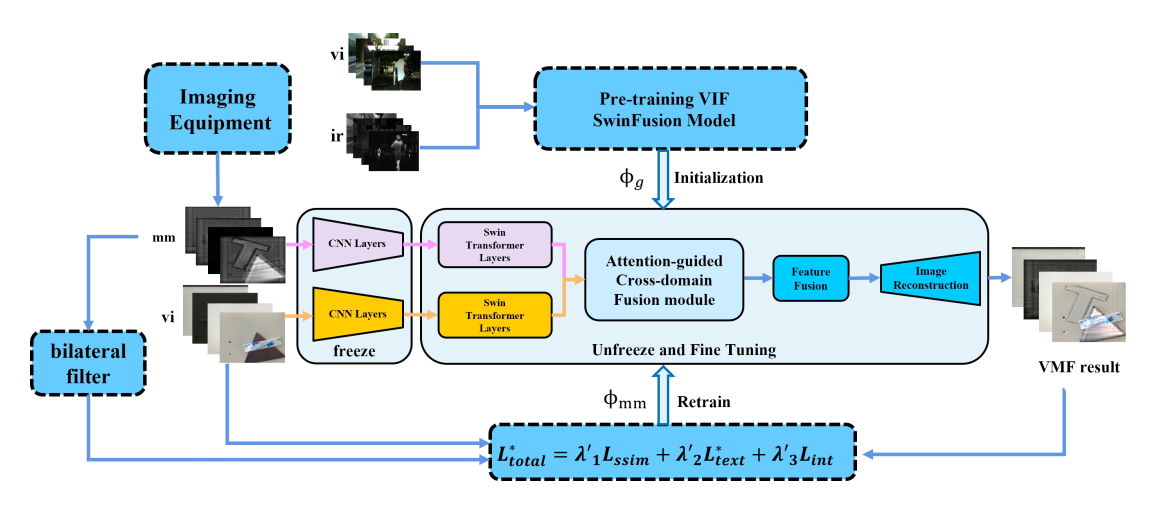

图1 基于SwinFusion的迁移学习方法的总体框架

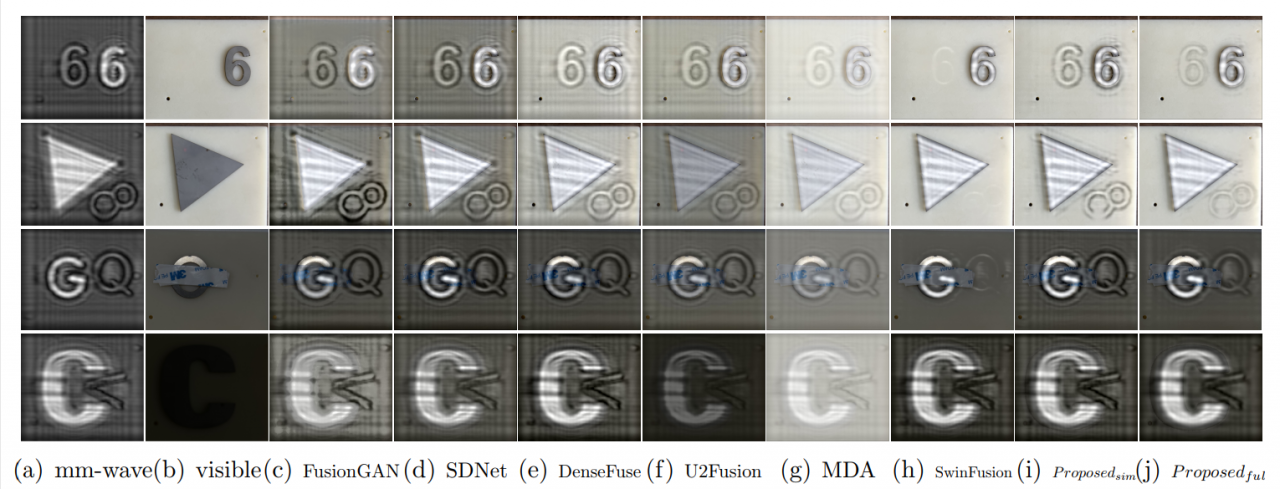

本研究提出了一种高效的近场毫米波透视与可见光图像融合方法,旨在克服粗粒度毫米波模态的信息稀疏问题,实现高分辨率的多模态图像融合。本研究基于深度学习中的迁移学习策略,应用典型SwinFusion框架,设计出一款从红外与可见光图像融合数据集中学习先验的信息融合算法,该算法能够有效地整合毫米波和可见光图像的互补信息。同时,通过引入双边滤波损失函数,显著提升了算法对毫米波图像摩尔纹噪声的抑制能力,确保融合结果在精度和鲁棒性方面均表现优异。实验结果表明,该方法在真实环境下展现了更高的融合精度与优异的目标检测效果,为多模态图像融合提供了新的解决思路,尤其适用于内部缺陷检测、目标定位等需要穿透成像的应用场景中,具有重要的实际应用价值。

此外,本研究构建了首个近场毫米波与可见光图像融合数据集(MMVI数据集),有助于研究者验证并优化个性化算法,推动近场雷达成像领域的发展。

图2 与现有图像融合方法进行对比(右一、二为提出的方法)

《Neural Networks》是全球神经网络领域的重要学术期刊,同时被SSCI和SCI收录,属于中科院大类一区Top期刊,CCF B类国际学术期刊。该期刊创刊于1988年,是神经网络研究领域历史最悠久的期刊之一,同时也是国际神经网络协会(INNS)、欧洲神经网络协会(ENNS)和日本神经网络协会(JNNS)三个历史最悠久的神经建模协会的档案期刊。该刊涵盖了神经网络、深度学习及其在各个领域的应用。

论文链接:https://www.sciencedirect.com/science/article/pii/S0893608024007238?dgcid=author

编辑:刘瑶 / 审核:李果 / 发布:陈伟