即可将网页分享至朋友圈

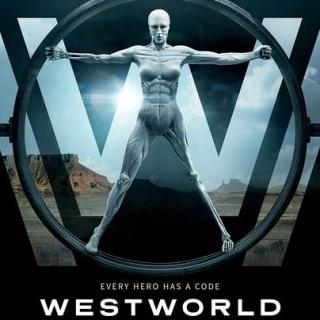

随着人工智能技术的不断发展,人类对人工智能的担心和疑虑也随之增长。对“技术驱逐人类”的传统哲学和伦理问题的讨论,将在人工智能时代掀起新的高潮。近日,正在热播的美剧《西部世界》,再次促发了观众对于人工智能的思考。

该剧呈现了一座以西部世界为主题的巨型高科技成人乐园。该乐园由私人公司经营,专门提供人工智能“接待员”,按照程序指令扮演一定的角色,供人类游客杀戮和娱乐。然而,随着这些人工智能“接待员”逐渐地产生了自主意识,它们开始怀疑这个世界的本质,进而觉醒并反抗人类。

人类为什么会如此恐惧人工智能呢?显然,并不是因为人工智能比人脑的功能更强大。人类创造人工智能,本来就是为了帮助人类放大、延伸大脑的功能。如果人工智能比人脑更弱,那么,它将失去存在的必要性。

从《西部世界》以及诸多同类型题材的影视作品中,我们可以看到,人类恐惧人工智能的第一个层次的原因,是人类从一开始就将人工智能定性为“工具”,对“工具”理所当然地采取“非人道”甚至残忍的态度,因此,人类害怕人工智能获得自主意识之后质疑这种“奴役秩序”的合理性,不再受人内控制、无法继续为人类服务。

更进一步,人类更加担心的是,“人工智能”在意识中复制了人类的“恶”,对人类产生更多的主观恶意甚至伤害和报复。通过《西部世界》,我们可以看到人类社会和人性中的黑暗面。这种黑暗通过技术投射到人工智能的“身体”当中,当受尽折磨的机器人暴起反抗时,就说出了难以置信的话:“狂暴的欢愉,必将以狂暴结局。”

也就是说,人类或许有一天能够保证人工智能具有“自我意识”,但无法保证能够消除机器人“觉醒”之后的恶念。当人们揣测机器人是否会复制人类的贪婪、自私、嫉妒、愤怒、狠毒、尔虞我诈时,人类首选需要扪心自问:机器人需要通过“机器学习”来产生意识,那么,人类到底要教给它什么?

因此,单从人工智能本身来推测其“自主意识”的善恶,是没有答案的,也是没有意义的。人类首先需要反省的是人类自身的文明。否则,即便人类最后像恐龙一样被灭绝,当人工智能成为世界上的“新物种”时,这个“新物种”又何尝不会复制人类今天的行为模式和“丛林法则”呢?

看过《变形金刚》系列电影的人可能记忆犹新:当世界上没有人的时候,那些机器人何尝不是分出或正或邪的派系对立,并为了争夺“能量块”而爆发宇宙大战呢?这何尝不是今天人类社会纷繁复杂、矛盾冲突的缩影呢?

正因如此,近日欧洲议会通过的一项呼吁全球禁止研发、生产和使用“杀人机器人”的决议,才显得弥足珍贵。欧洲议会安全政策发言人称,“自动武器必须在全球范围内予以禁止,决定生死的权力绝不能被机器从人类手中夺走。”

“杀人机器人”全称为“致命性自主武器系统”,BBC曾以“永不睡觉的士兵”来形容它。它是一种用以代替人类士兵的全自动智能机器人,可以在无人操控的情况下自动选择攻击目标并实施攻击,从最初的由人远程控制,发展至由计算机程序和传感器装置控制,进而进化为全自动识别、判断并实施军事打击行动。

据报道,随着科技的进步、人工智能的发展,全自动武器发展迅速。美国、韩国、俄罗斯、以色列、英国、澳大利亚等国家都在“杀人机器人”的研发上增加投入、颇下功夫。近年来,虽然禁止“杀人机器人”研究的呼声不绝,但很遗憾,在人类目前的文明水平下,要达成这一共识几乎是天方夜谭。

试想,人类尚且无法让所有国家在“全球气候公约”上签字,又如何能让所有国家都禁止研究“杀人机器人”呢?还记得丁仲礼院士在谈到全球气候问题的根本解决之道时说:“能够拯救人类的也只有人类自己,那就是在这个和而不同的世界产生更具包容性的文明。”显然,这句话对解决人工智能的伦理困扰也同样适用。

如果人类无法形成包容性的文明,如果人类依然是今天这样战火纷飞的“丛林世界”,那么,不用等人工智能像《西部世界》中所表现的那样产生自我意识后“觉醒”,人类现在就已经主动开发越来越多、越来越先进的“杀人机器人”,然后靠“杀人机器人”不断相互消灭敌对的人类,最后留下满世界的狼藉。

可见,人类对人工智能的恐惧其实是一个伪问题。人类恐惧的,正是人类自身。正所谓“解铃还须系铃人”,对人工智能的伦理问题的考量,还得从人类自身的伦理问题着手。

编辑:王晓刚 / 审核:王晓刚 / 发布:王晓刚